محققان الگوریتم هوش مصنوعی قابل توضیح را ایجاد می کنند

بر اساس هوش مصنوعی ، محققان دانشگاه تورنتو و LG AI Research یک الگوریتم "قابل توضیح" هوش مصنوعی (XAI) ایجاد کرده اند که می تواند به شناسایی و رفع نقص در صفحه نمایش کمک کند.

الگوریتم جدید ، که نسبت به معیارهای صنعت عملکرد بهتری داشته ، از طریق یک همکاری تحقیقاتی AI بین LG و U of T توسعه یافته است که در سال 2019 با تمرکز بر کاربردهای هوش مصنوعی برای مشاغل توسعه یافته است.

محققان می گویند الگوریتم XAI به طور بالقوه می تواند در زمینه های دیگری که نیاز به دریچه ای در مورد چگونگی تصمیم گیری یادگیری ماشین دارد ، از جمله تفسیر داده ها از اسکن های پزشکی ، اعمال شود.

Kostas Plataniotis ، استاد بخش مهندسی برق و کامپیوتر ادوارد S. Rogers Sr. در دانشکده کاربردی می گوید: "توضیح و تفسیر پذیری در مورد رعایت استانداردهای کیفی است که ما به عنوان مهندس برای خود تعیین کرده ایم و کاربر نهایی آن را درخواست می کند." علوم و مهندسی "با XAI ، هیچ" اندازه ای متناسب با همه وجود ندارد. " باید بپرسید که برای چه کسی آن را توسعه می دهید؟ آیا برای توسعه دهنده دیگری برای یادگیری ماشین است؟ یا برای پزشک یا وکیل است؟ "

این تیم تحقیقاتی همچنین شامل مهندس اخیر مهندس T مهندسی سودهاکار و نامزد کارشناسی ارشد سام ستارزاده و همچنین محققانی به رهبری Jongseong Jang در LG AI Research Canada - بخشی از بازوی تحقیق و توسعه جهانی این شرکت بود.

XAI یک زمینه نوظهور است که به موضوعاتی با رویکرد "جعبه سیاه" استراتژی های یادگیری ماشین پرداخته است.

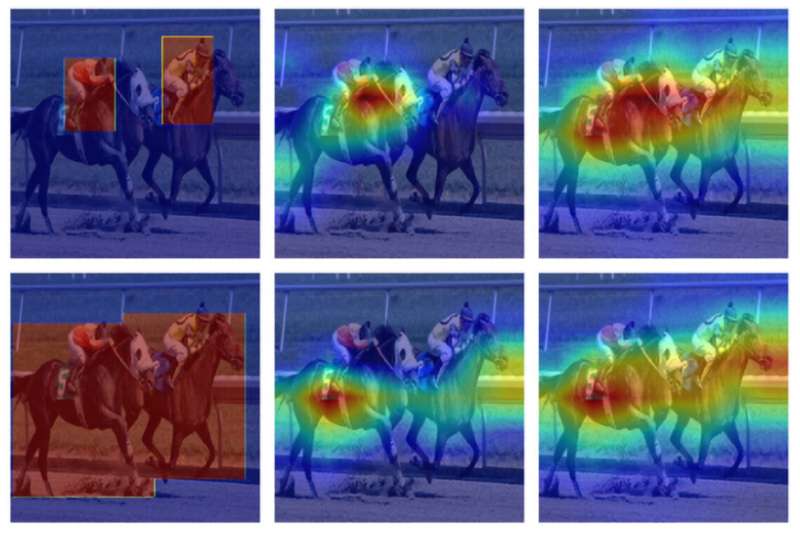

در یک مدل جعبه سیاه ، ممکن است مجموعه ای از داده های آموزش در قالب میلیون ها تصویر دارای برچسب به رایانه داده شود. با تجزیه و تحلیل داده ها ، الگوریتم یاد می گیرد که ویژگی های خاصی از ورودی (تصاویر) را با خروجی های خاص (برچسب ها) مرتبط کند. در نهایت ، می تواند به درستی برچسب هایی را به تصاویری که قبلاً هرگز ندیده است ، متصل کند.

دستگاه به خودی خود تصمیم می گیرد که به کدام جنبه های تصویر توجه کند و کدام یک را نادیده بگیرد ، یعنی طراحان آن هرگز دقیقاً نمی دانند که چگونه به نتیجه می رسد.

اما چنین مدل "جعبه سیاه" وقتی در زمینه هایی مانند مراقبت های بهداشتی ، حقوقی و بیمه اعمال شود ، چالش هایی به وجود می آورد.

سوداکار می گوید: "به عنوان مثال ، یک مدل [یادگیری ماشین] ممکن است تعیین کند که یک بیمار 90 درصد احتمال تومور دارد." "پیامدهای اقدام به اطلاعات نادرست یا مغرضانه به معنای واقعی کلمه مرگ یا زندگی است. برای درک و تفسیر کامل پیش بینی مدل ، پزشک باید بداند که الگوریتم چگونه به آن رسیده است."